Dlaczego OCR nie rozpoznaje polskich znaków w starych dokumentach?

Dlaczego OCR nie rozpoznaje polskich znaków w starych dokumentach?

Zastanawiasz się, dlaczego OCR nie rozpoznaje polskich znaków w starych dokumentach? To pytanie zadaje sobie wielu menedżerów i specjalistów zajmujących się digitalizacją. W erze, gdy automatyzacja procesów staje się normą, a elektroniczny obieg dokumentów to podstawa efektywnego zarządzania, napotkanie na takie przeszkody może być frustrujące.

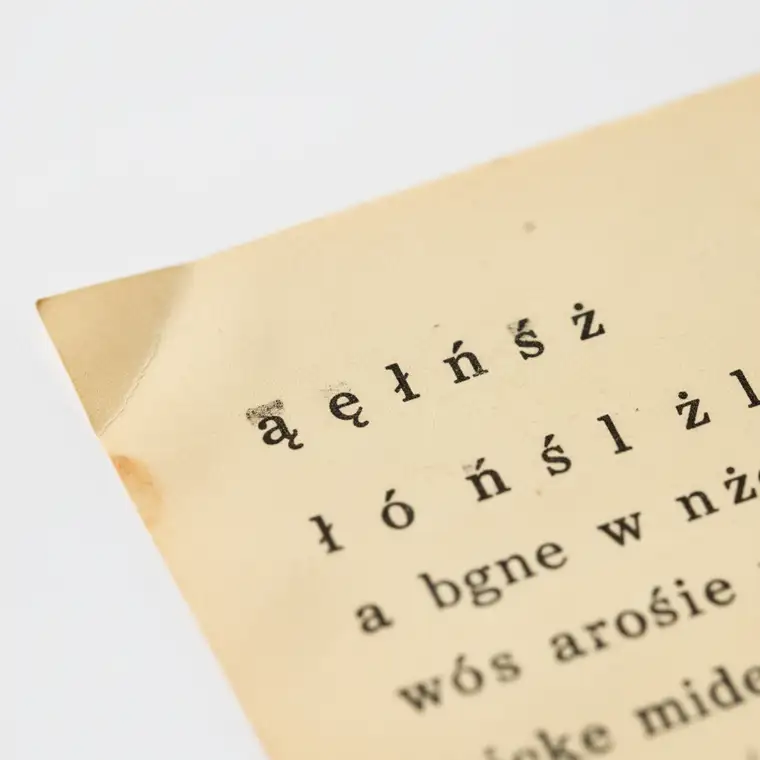

Próba przetworzenia archiwów pełnych starych faktur, umów czy pism urzędowych często kończy się rozczarowaniem. System OCR (Optical Character Recognition) bezbłędnie radzi sobie z angielskim tekstem, ale w przypadku polszczyzny gubi się przy literach takich jak „ą”, „ę”, „ł”, „ń”, „ó”, „ś”, „ź”, „ż”.

Dlaczego tak się dzieje i jak sobie z tym poradzić? Aby zrozumieć sedno problemu, musimy spojrzeć na proces OCR oraz specyfikę starych dokumentów z kilku perspektyw. Nie jest to kwestia jednej, prostej przyczyny, ale raczej splotu wielu czynników, które wspólnie utrudniają skuteczne rozpoznawanie tekstu.

W dalszej części artykułu przeanalizujemy najważniejsze przyczyny tych trudności oraz przedstawimy skuteczne rozwiązania, które realnie poprawiają jakość rozpoznawania polskich znaków w archiwalnych dokumentach. To pozwoli lepiej zaplanować proces digitalizacji i uniknąć wielu kosztownych błędów.

Kluczowe przyczyny problemów z OCR w starych dokumentach

1. Niska jakość oryginalnych dokumentów i ich degradacja

Stare dokumenty to często materiały, które przeleżały dziesiątki lat w archiwach, magazynach czy piwnicach. Czas jest dla nich bezlitosny, a degradacja nośnika bezpośrednio przekłada się na skuteczność OCR. Papier z biegiem lat żółknie, staje się kruchy, a jego powierzchnia nierówna.

Włókna papieru mogą się rozpadać, tworząc drobne „szumy” na skanie, które algorytm OCR może błędnie interpretować jako fragmenty znaków lub przeszkody. Do tego dochodzi blaknięcie tuszu i atramentu – tekst bywa wyblakły, częściowo zanikły, a w przypadku ręcznie pisanych pism często widoczne są jedynie cienie liter.

Dodatkowym problemem są zagniecenia, zabrudzenia, plamy po kawie czy wodzie, rozerwania i ubytki kartek. Wszystko to wprowadza do obrazu chaos, który dezorientuje algorytmy rozpoznawania tekstu. Taki „szum” bywa mylony z elementami liter, co prowadzi do licznych błędów, zwłaszcza w przypadku drobnych polskich znaków diakrytycznych.

W efekcie system OCR w wielu miejscach widzi jedynie fragmentaryczne kształty. „Ogonki” i „kreski” mogą być częściowo przykryte plamami, rozmyte lub zbyt blade. W takich warunkach literę „ą” algorytm łatwo odczyta jako „a”, a „ń” jako „n”, pozbawiając tekst poprawnej formy językowej i znacznie obniżając jego wartość użytkową.

2. Specyfika dawnego druku i zapisu

Metody tworzenia dokumentów w przeszłości znacznie różniły się od współczesnych wydruków laserowych czy atramentowych. Wiele starych dokumentów powstało na maszynach do pisania, które zostawiały nieidealne odciski, z nierównomiernym natężeniem czerni.

Charakterystyczne jest też zjawisko „przebijania” tekstu na drugą stronę kartki, szczególnie na cienkim papierze. Na skanie widać więc jednocześnie treść z obu stron, co jest dla OCR ogromnym wyzwaniem. Starodruki z nierównomiernym rozłożeniem tuszu dodatkowo komplikują sytuację – litery bywają rozmyte lub zlewają się ze sobą.

Kolejnym utrudnieniem jest różnorodność czcionek. Dawniej używano szerokiej gamy fontów, często ozdobnych lub niestandardowych. Maszyny do pisania miały własne, specyficzne kroje, nierzadko z drobnymi deformacjami liter wynikającymi z eksploatacji. Nowoczesne systemy OCR są optymalizowane pod kątem współczesnych, wyraźnych krojów systemowych, a nie historycznych fontów.

W przypadku polskich znaków problem jest szczególnie widoczny. Litery takie jak „ą”, „ę”, „ł”, „ń”, „ó”, „ś”, „ź”, „ż” zawierają dodatkowe elementy – ogonki, kreski, kropki. W połączeniu z niską jakością druku, degradacją papieru czy słabym skanem detale te stają się trudne do uchwycenia. „Ł” może zostać rozpoznane jako „l”, „ś” jako „s” lub nawet „f”, a „ó” jako „o”, co kompletnie zmienia sens wielu słów.

3. Ograniczenia starszych wersji oprogramowania OCR

Technologia OCR ewoluuje w błyskawicznym tempie, ale wiele organizacji wciąż korzysta z przestarzałych rozwiązań, które nie radzą sobie dobrze z polszczyzną. Starsze algorytmy bywały projektowane głównie pod kątem języka angielskiego i innych języków bez rozbudowanych znaków diakrytycznych.

Takie systemy często nie posiadały odpowiednich słowników i modeli językowych dostosowanych do języka polskiego. Bez wiedzy, że w polszczyźnie występują charakterystyczne zbitki typu „ch”, „rz” czy „sz”, algorytm gorzej radzi sobie z korekcją błędów rozpoznawania pojedynczych znaków. Brak głębszego modelu językowego oznacza też mniejszą zdolność do domyślania się właściwego słowa na podstawie kontekstu zdania.

Dawne systemy OCR miały również mniej zaawansowane mechanizmy przetwarzania obrazu. Słabo radziły sobie z prostowaniem przekrzywionych stron (deskewing), usuwaniem szumów (despeckling) czy poprawą kontrastu. Bez tych operacji wstępnych, obraz trafiający do silnika rozpoznawania jest już mocno zdeformowany, co szczególnie uderza w drobne elementy polskich znaków.

Brak szerokiego wykorzystania uczenia maszynowego i sztucznej inteligencji powodował, że starsze rozwiązania były oparte na sztywnych regułach i statycznych bibliotekach wzorców. W efekcie są one znacznie mniej elastyczne w obliczu niestandardowych sytuacji, takich jak archiwalne dokumenty o różnej jakości, typie druku czy stopniu zniszczenia.

Jak jakość skanowania wpływa na polskie znaki?

4. Jakość skanowania i przygotowania dokumentów

Nawet najlepszy system OCR nie poradzi sobie, jeśli otrzyma słaby „surowiec”. Jakość skanowania jest jednym z najważniejszych czynników wpływających na to, czy polskie znaki zostaną poprawnie rozpoznane. Skanowanie w zbyt niskiej rozdzielczości, np. poniżej 300 DPI, prowadzi do utraty detali niezbędnych dla liter z ogonkami i kreskami.

Przy niskiej rozdzielczości „ogonki” czy „kreski” mogą po prostu zniknąć z obrazu, zanim trafią do OCR. Dodatkowo, nieodpowiednie ustawienia jasności, kontrastu czy zbyt agresywna kompresja pliku (np. niski jakościowo JPG) sprawiają, że tekst staje się rozmyty lub poszarpany. To wszystko utrudnia prawidłową interpretację szczególnie wrażliwych polskich znaków.

Problemy pojawiają się także przy nieprawidłowym kadrowaniu i orientacji dokumentu. Przekrzywione strony, przycięte fragmenty tekstu czy pomieszane kolejności stron wydłużają i komplikują cały proces rozpoznawania. Algorytm traci orientację, a wynikiem są częste pomyłki, dziwne podziały wyrazów czy błędne rozpoznawanie liter.

Dlatego przygotowanie dokumentów do skanowania – ich oczyszczenie, wyrównanie, a nawet czasem mechaniczne wyprostowanie – staje się ważnym etapem procesu digitalizacji. Bez tego trudno oczekiwać, że nawet zaawansowany OCR poradzi sobie z odczytem polskich znaków w sposób satysfakcjonujący.

Skuteczne rozwiązania: jak poprawić rozpoznawanie polskich znaków?

Skoro znamy już główne przyczyny, pora przejść do konkretnych, praktycznych działań. Rozwój technologii sprawia, że z wieloma problemami da się skutecznie poradzić, o ile proces digitalizacji zostanie dobrze zaplanowany.

1. Skanowanie w wysokiej jakości

Pierwszym i absolutnie podstawowym krokiem jest skanowanie w odpowiedniej rozdzielczości. Stare dokumenty warto skanować w co najmniej 300 DPI, a w przypadku trudnych materiałów – 400–600 DPI. Dobrze jest używać trybu w odcieniach szarości lub w kolorze, aby zachować jak najwięcej detali.

Należy zadbać o czystość szyb skanera oraz równomierne oświetlenie, aby nie tworzyć dodatkowych cieni czy odbić. Przy szczególnie cennych i delikatnych archiwaliach warto rozważyć profesjonalne usługi skanowania, które dysponują sprzętem pozwalającym minimalizować ryzyko uszkodzeń dokumentów i jednocześnie generować najwyższą możliwą jakość obrazów.

Im lepszy skan, tym większa szansa, że drobne ogonki, kropki i kreski związane z polskimi znakami zostaną poprawnie odczytane. Inwestycja w jakość na tym etapie zwraca się wielokrotnie na późniejszych etapach pracy z cyfrowym archiwum.

2. Wstępne przetwarzanie obrazu przed OCR

Zanim obraz trafi do silnika OCR, warto go wstępnie przetworzyć. Większość nowoczesnych oprogramowań do skanowania i zarządzania dokumentami oferuje zestaw funkcji, które znacząco poprawiają czytelność tekstu.

Do kluczowych narzędzi należą:

- Deskewing (prostowanie obrazu) – automatyczne wyrównywanie przekrzywionych stron, co poprawia rozpoznawanie linii tekstu.

- Despeckling (usuwanie szumów) – eliminowanie drobnych kropek, plamek i zakłóceń, które mogą być mylone z fragmentami liter.

- Binarization (konwersja do czarno-białego) – zwiększanie kontrastu między tekstem a tłem, ułatwiające wyodrębnienie znaków.

Dodatkowo przydatne jest automatyczne przycinanie i usuwanie obramowania, dzięki czemu do OCR trafia wyłącznie właściwy obszar z tekstem. W połączeniu te operacje istotnie zwiększają szanse na poprawne rozpoznawanie polskich znaków, ponieważ wyraźniej oddzielają je od tła i zakłóceń.

3. Wybór nowoczesnego oprogramowania OCR z obsługą języka polskiego

Kolejnym kluczowym elementem jest wybór nowoczesnego systemu OCR, który został zaprojektowany z myślą o językach środkowoeuropejskich, w tym polskim. Takie rozwiązania uwzględniają specyfikę polskiej ortografii, oferując dedykowane słowniki i modele lingwistyczne.

Nowoczesne narzędzia coraz częściej wykorzystują sztuczną inteligencję i deep learning, ucząc się na ogromnych zbiorach danych. Dzięki temu lepiej radzą sobie z rozpoznawaniem zdegradowanego tekstu oraz z drobnymi różnicami w krojach czcionek. Są też bardziej odporne na niestandardowe warunki, jakie występują przy digitalizacji starych dokumentów.

W praktyce oznacza to wyższy procent poprawnie rozpoznanych polskich znaków, mniejszą liczbę oczywistych błędów oraz lepsze dopasowanie słów do kontekstu zdania. Dobrze dobrane oprogramowanie OCR staje się więc jednym z filarów skutecznej digitalizacji archiwów.

4. Post-OCR edycja i weryfikacja

Nawet najlepszy system OCR nie jest w 100% nieomylny, zwłaszcza przy trudnych, zniszczonych dokumentach. Dlatego zawsze warto założyć, że potrzebna będzie ręczna weryfikacja i korekta wyników.

Praktycznym wsparciem są rozwiązania pozwalające na wygodne porównywanie rozpoznanego tekstu z oryginalnym obrazem. Funkcje podświetlania potencjalnych błędów, oznaczania wątpliwych fragmentów czy szybkiego przechodzenia między wersją tekstową a graficzną znacząco przyspieszają pracę.

Choć post-OCR edycja jest czasochłonna, jest też niezbędna, jeśli zależy nam na wysokiej jakości danych. Szczególnie istotne jest dokładne sprawdzanie miejsc, w których często występują polskie znaki, oraz newralgicznych elementów dokumentów, takich jak nazwy własne, dane osobowe czy kluczowe fragmenty umów.

5. Hybrydowe podejście: OCR + człowiek

W przypadku bardzo starych, mocno zniszczonych lub ręcznie pisanych dokumentów pełna automatyzacja może się okazać nierealna. Tutaj sprawdza się hybrydowe podejście, łączące OCR z pracą człowieka.

W praktyce wygląda to tak, że łatwiejsze fragmenty dokumentów są przetwarzane automatycznie, natomiast szczególnie problematyczne części trafiają do operatora. Część firm oferuje usługi typu „human-in-the-loop”, w których operatorzy weryfikują i poprawiają rozpoznany tekst, szczególnie tam, gdzie algorytm zgłasza niską pewność.

Takie podejście pozwala z jednej strony korzystać z szybkości i skalowalności automatycznego OCR, a z drugiej zachować wysoką dokładność w miejscach krytycznych. Jest to często najlepsze rozwiązanie przy digitalizacji archiwów o dużej wartości historycznej lub prawnej.

6. Trenowanie własnego systemu OCR (dla zaawansowanych)

Dla organizacji dysponujących dużymi, specyficznymi zbiorami dokumentów ciekawą opcją jest trenowanie własnych modeli OCR. Niektóre zaawansowane platformy umożliwiają dostosowanie algorytmu do konkretnego typu dokumentów, krojów pisma czy układów stron.

Takie podejście jest szczególnie przydatne przy pracy z historycznymi rękopisami, starodrukami lub dokumentami powstającymi w jednej, charakterystycznej technologii. System uczy się rozpoznawać specyficzne cechy liter i słów, a z czasem znacząco poprawia swoją dokładność.

Choć jest to rozwiązanie bardziej złożone i wymagające odpowiedniej infrastruktury, może przynieść znakomite efekty w długim okresie. Szczególnie wtedy, gdy kluczowe jest jak najwierniejsze odtworzenie oryginalnej treści, w tym wszystkich polskich znaków diakrytycznych.

Podsumowanie

Digitalizacja starych dokumentów to proces pełen wyzwań, ale przy odpowiednim podejściu jest to cel w pełni osiągalny. Problem z tym, dlaczego OCR nie rozpoznaje polskich znaków w starych dokumentach, wynika najczęściej z kombinacji słabej jakości oryginałów, specyfiki dawnych technologii druku, ograniczeń starszego oprogramowania oraz niewłaściwej jakości skanów.

Stosując wysokiej jakości skanowanie, wstępne przetwarzanie obrazu, nowoczesne rozwiązania OCR z pełną obsługą języka polskiego oraz świadomą post-OCR weryfikację, można znacząco poprawić skuteczność rozpoznawania polskich znaków. W trudniejszych przypadkach warto sięgnąć po hybrydowe podejście lub trenowanie własnych modeli.

Inwestycja w dobrze zaplanowany proces digitalizacji oraz odpowiednie narzędzia OCR to inwestycja w przyszłość organizacji i efektywne zarządzanie informacją. Dzięki temu nawet wieloletnie archiwa mogą stać się łatwo przeszukiwalnym, wartościowym zasobem, w którym polskie znaki nie będą już barierą, lecz naturalnym elementem w pełni dostępnej treści.